はじめに

AI(人工知能)技術の進化により、私たちの生活やビジネスに大きな変化がもたらされています。しかし、その一方で「AIの判断は本当に公平なのか」「プライバシーは守られるのか」といった倫理的な懸念も高まっています。

たとえば、AIを活用した採用システムが無意識のうちに性別や年齢による偏見を持ってしまったり、顔認識技術によって個人のプライバシーが侵害される可能性が指摘されています。また、自動運転車が事故を起こした際に責任は誰が負うべきなのかといった問題も議論されています。

こうした課題に対応するため、日本でもAI倫理に関する取り組みが進んでおり、政府や企業がガイドラインを策定しています。今回は日本におけるAI倫理の現状と課題、そして具体的な対策について基礎を解説したいと思います!

結論

近年、AI倫理の重要性はますます高まっています。

AIの公平性や透明性を確保し、プライバシーを守ることが求められています。

AIの意思決定に対する責任を明確にすることも課題となっています。

AI倫理とは?

AI倫理とは、人工知能(AI)の開発や利用において、人間の価値観や社会的な責任を考慮し公正で安全な運用を目指すための考え方です。

AIが急速に発展する中で、その利用が社会に与える影響が大きくなっています。特に、日本では労働力不足の解消や産業の効率化を目的にAIの導入が進められていますが、一方で倫理的な問題も指摘されています。

たとえば、AIが判断を下す際の透明性や公平性、プライバシーの保護、さらには人間の仕事を奪うリスクなどが議論の対象になっています。

こうした背景から、日本においてもAIの倫理的な利用を促進するためのガイドラインが作成され、企業や研究機関が倫理的な開発・運用を求められるようになっています。

日本におけるAI倫理の課題

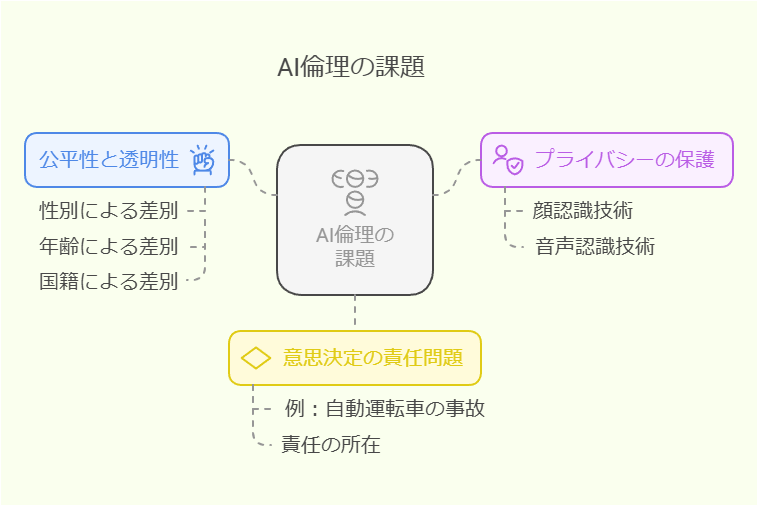

日本におけるAI倫理の課題は主に以下の点に集約されます。

まず、公平性と透明性の確保が挙げられます。AIは学習するデータによって判断を下しますが、そのデータに偏りがあると、不公平な結果を生む可能性があります。たとえば、採用試験でAIを活用する場合、過去のデータに基づいた判断が性別や年齢による差別を助長してしまうことがあります。

次に、プライバシーの保護が重要な問題です。顔認識技術や音声認識技術の発展により、個人情報の収集や利用が容易になっています。しかし、適切な管理が行われなければ個人のプライバシーが侵害されるリスクがあります。

さらに、AIによる意思決定の責任問題も指摘されています。たとえば自動運転車が事故を起こした場合、その責任を誰が負うのかが明確でないケースがあります。開発者や利用者、企業の間で責任の所在を明確にする仕組みが求められています。

日本におけるAI倫理の対策

日本ではAI倫理に関する取り組みが進められており、さまざまな対策が講じられています。

まず、日本政府は「7つのAI原則」を策定し、公正性・透明性・安全性などを重視する方針を打ち出しました。この原則に基づき、企業や研究機関がAIの倫理的な運用を行うよう求められています。

また、企業レベルでもAI倫理の指針を定める動きが活発化しています。たとえば、大手IT企業はAIの公平性やプライバシー保護に関する内部規定を設け、開発プロセスに倫理的な視点を取り入れています。

さらに、大学や研究機関でもAI倫理に関する研究や教育が進められています。エンジニアやデータサイエンティストが倫理的な視点を持つことが重要視され、教育プログラムにAI倫理を組み込む動きが広がっています。

まとめ

日本におけるAI倫理の重要性はますます高まっています。AIの公平性や透明性を確保し、プライバシーを守ることが求められています。また、AIの意思決定に対する責任を明確にすることも課題の一つです。

日本政府や企業、大学や研究機関はAI倫理に関するガイドラインを策定し、安全で公正なAIの開発と運用を推進しています。今後も技術の発展とともに倫理的な側面を重視しながら、持続可能なAI社会の実現を目指すことが求められます。

最後まで読んでいただき、ありがとうございました!